医師国家試験をChatGPTに解いてもらった|医師の将来需要と人工知能とキャリア方針(私見)

話題の「ChatGPT」に医師国家試験(2023年実施の第117回)の問題を解いてもらったので、シェアしたいと思います。

結論から言うと、ChatGPTの正答率は甚だ低く、現時点では国家試験合格までは至らなさそうでした。厚労省による公式の解答発表がまだなので、確定的な試験成績は算出できませんが、必修問題の正答率が50~60%ほどでした。(*必修問題は、80%を取っていなければ受験生は足切りされてその時点で不合格となります。)

ChatGPTと医師国試については、以下の動画でも説明しているのでぜひご覧ください。(以下記事内容との重複はありません)

ChatGPT自身に医師国試に合格できるか聞いた

国家試験は5択問題が基本なので、完全にランダムなら正答率は20%ほどになります。この率はChatGPTでも十分に超えていました。体感としては、医学的知識を正しく学習させれば、AIが医師の国家試験に合格できる日も早晩やってきそうですし、もう来てるかもしれません。医師国家試験の問題の多くは過去問からの焼き直し問題なので、出そうなポイントに絞って学習させれば効率よく得点を狙えそうです。

合格の可否について、ChatGPT自身は以下のように答えました。

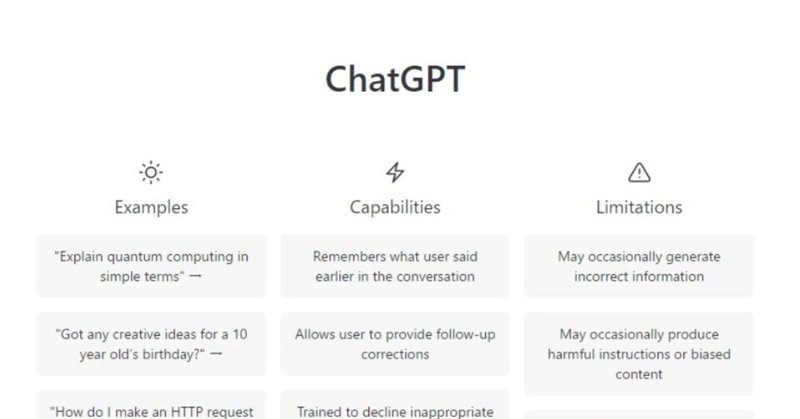

ChatGPTは、自らを「自然言語処理モデルであり、テキストデータに基づいて回答を生成」していると答えました。全くその通りで、ChatGPTの利用法としては、自然言語を生成することに主眼を置くのが本来であると感じます。内容の正しさや試験問題に正解できるか否かを検討するのは、ChatGPTの本来の目的とはズレており、あまり正しくないんです(と分かっていながら国試を解かせました…)。実際、ChatGPTが生成した上記テキストも後半は間違っています(医師国家試験に技能試験はないです)。

念のため再度、ChatGPTに問い直してみました。

医師国家試験に実技試験はなく、面接試験もないので、このChatGPTの回答内容もほとんど誤り。複数回にわたって行われませんし、筆記試験というよりも、マークシート式です。

なめらかな回答を生成する割に、やっぱり中身が誤っており、どこか心理的な違和感を覚えます。詐欺師の言葉が、自信にあふれ流暢であれば、人はそれを信じてしまいがちなのと似ているかもしれないと感じました。ChatGPTの流暢さと中身の荒唐無稽具合とのギャップに違和感を覚えてしまいます。

ただ、流暢な言葉を生成する性能については優れていて、これについて活用できる場所はたくさんあると感じます。流暢だからこそ、中身の間違いが際立つのかと思います。

AIで医師需要が減るのか、に対して私見および私が目指したいもの

以下は私の私見であり、なりたい医師像でもあります。

AIは簡単な診断の補助などができると思いますが、そうじゃないのは当分は無理だと思います。簡単な診断というのは例えば「インフルエンザ流行期の感冒症状と急な高熱に対して、抗原検査を提案し、陽性だったので抗ウイルス薬を処方」といったイメージです。しかし、この患者が検査で陰性だったらどうでしょうか、偽陰性でしょうか、他の病気でしょうか? 人間の医師が患者の社会的背景や表情・しぐさなどから情報を推察するのと同じようなことを、機械ができるようになるのはもっとずっと先だと感じます(こういうのはデータ化されづらいから難易度がずっと高い気がするけどどうでしょうか?)

AIが既に答えのあるデータを基に回答を返すとしたら、答えの出ない問題に対処する方法のイメージを私は持てません。典型的には、例えば治療法のない疾患に対する治療法をGoogleに聞いても答えは示されません(誰も知らないことの答えはネットにもない)。あるいは、治療法のない状態に陥ってしまった患者に対してはどうしましょうか。AIなら「治療法はありません」「苦痛を和らげる方法はあり、選択肢は…」など言えるかもしれませんが、苦痛は、身体的なものだけではないのです。人間がみることが必要だと思います。

最後に、新しい技術が増えれば人手が要らなくなる、というのは多くが幻想だと私は思っています。新しい技術に関わる新しい人材が必要になります。結果的には、以前より多くの人(材)が必要になることのほうが多いのではないでしょうか? 医師は人間の生死にかかわるこそ、歴史上古くから存在した職業の一つであるし、今後形を変えても、存在し続けると思います。人間は生老病死から逃れられないからです。医師に限りませんが、必要なのは適応力や柔軟性だと思っています。

この記事が気に入ったらサポートをしてみませんか?