世界最大のSEOイベントであるPubconで語られた「上級編SEO講座(1)」

世界最大のSEOイベント、Pubconに来ています。ここではPubconで語られた最新情報を書き起こしつつ日本語に翻訳する形で記事にしています。日本人参加者はかなり少ないようなので、日本語で閲覧できる記事としては、最新情報と言い切っても過言ではないでしょう。ウェブ解析士協会の江尻代表のお陰で参加できたので、改めて感謝させていただきます。

では、見ていきましょう。

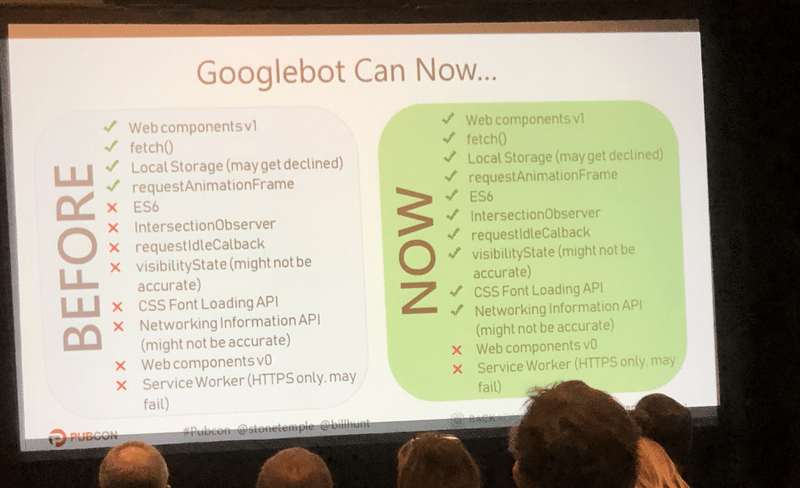

Googlebotの最新バージョンは何ができて、何ができないのか。

GoogleBotのこれまでと今現在の違いは、上の表にまとめているので、見て欲しい。

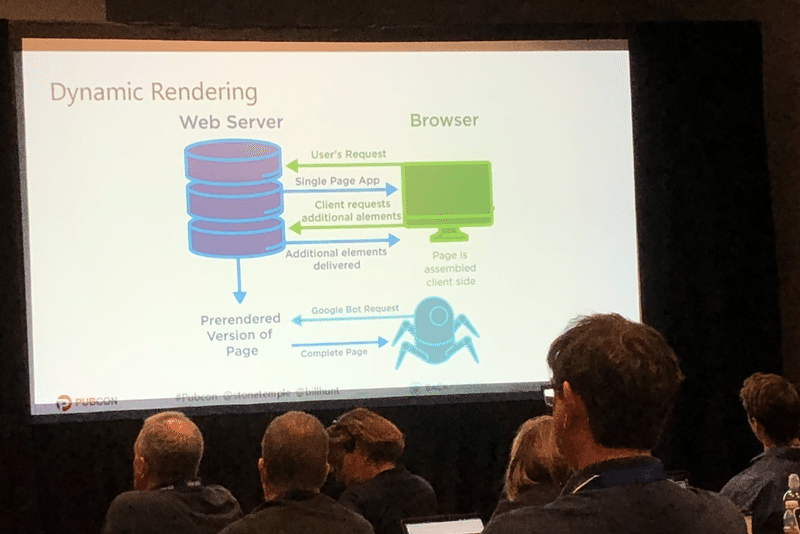

2種類のレンダリングの仕組み

そして、実際には2種類のレンダリング方法がある。それはサーバーサイドレンダリングとダイナミックレンダリングの2種類だ。

1)サーバーサイドレンダリング

ユーザーのリクエストはブラウザgから行われ、サーバーはSingle Page Appを返す。そして、クライアントリクエストからalementesを追加する。そして、追加されたコンテンツを返す。

2)ダイナミックレンダリング

これにGoogleBotのリクエストが入ると、Webサーバーは完璧なページを返す。上のサーバーサイドレンダリングに足されている考え方だ。これはAngularJSなどで取り入れられている。

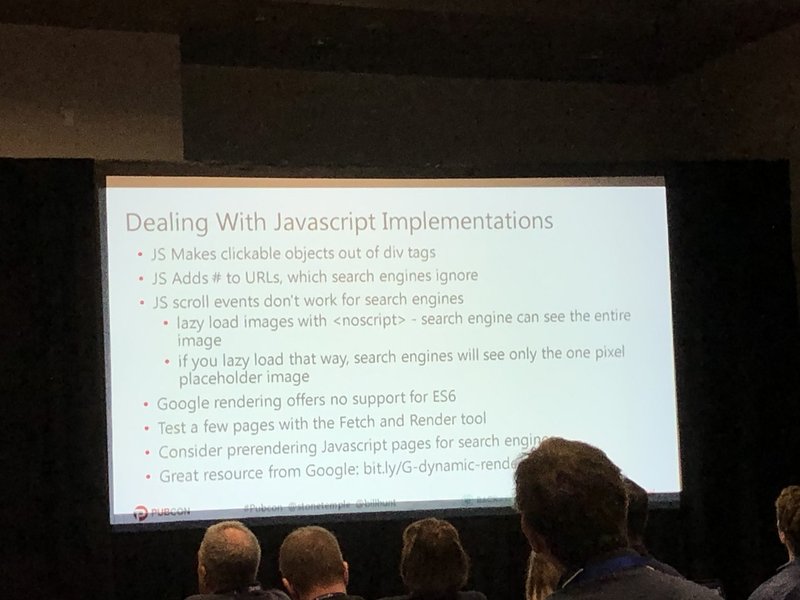

- JSはクリック可能なdivタグを返す。

- JSは#をURLに入れて、検索エンジンに無視させる。

- JSスクロールイベントは検索エンジンでは動かない

- lazy loadの画像は<noscript>で。そうすれば、検索エンジンは全ての画像を見れる

- lazy loadをそのやり方でやれば、1つの画像だけを見てくれる

- GoogleのレンダリングはES6をサポートしない。

- いくつかのページをFetch and Renderでテストすると良い

インデックスされるということは稼げるということ

実際のところ、GoogleにとってWEBページは大量にあり、個別のページをインデックスする必要はなくなっている。一方、インデックスされると、その分、アクセスは上がり稼ぎやすくなる。そのため、XML Sitemapを入れて通知することが大切だ。

- 全てのURLを入れる

- ユーザーのためではなく、Botのためにデザインする

- 全てのページをインデックスさせるために設計する

- インデックスを助ける

- ページの変更を理解させるスピードを早くする

などの良さがあります。

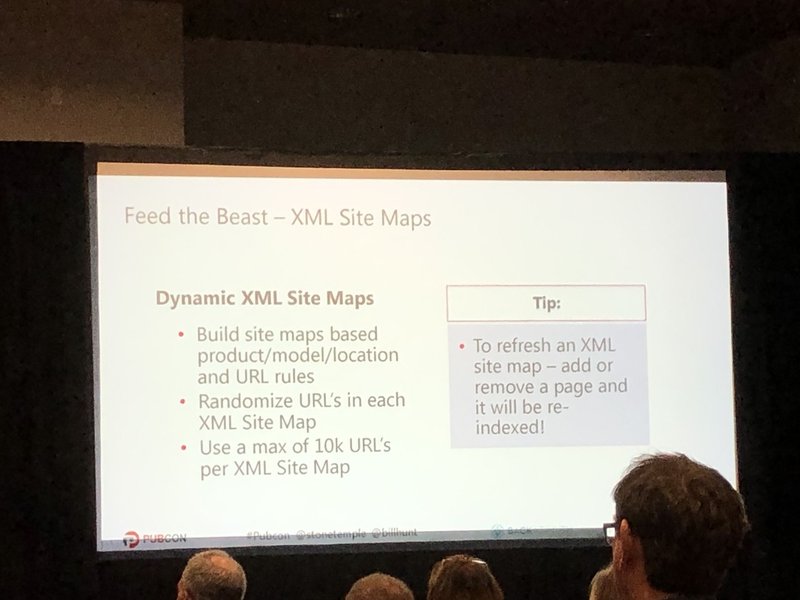

一方で、Dynamic XML Site Mapsという考え方があります。

- product/model/locationごとにURLのルールを変えます。

- URLをランダムにします。

- 10kを上限にURLを1つのXML Site Mapごとに格納します。

XMLの質をモニタリングしよう。

- 1%以下のエラー率になっているか。

- 200 headerを全てのページが返してくれるか。

- フォーマットはあっているか。

- XML Site Mapのインデックスレートはどうなっているか。

などを確認するようにしましょう。

Robot.txt Sculptingはうまくいかない。

これは今はめちゃくちゃなアスキーアートみたいになっている。

- 619の列が除外されている。

- 理解がしづらい構成になっている。

- 75%ものWebページが効率的に取得されなくなる。

そのため、このやり方でやると、エラー率が大幅に上がってしまい、クローリングするのが非常に難しくなる。実験してみたところ、14.6Mものエラーが出てしまった。

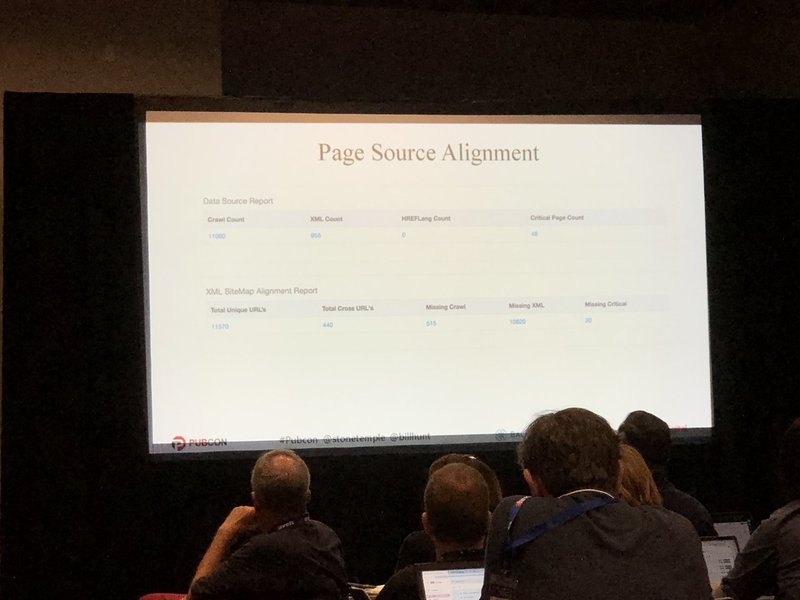

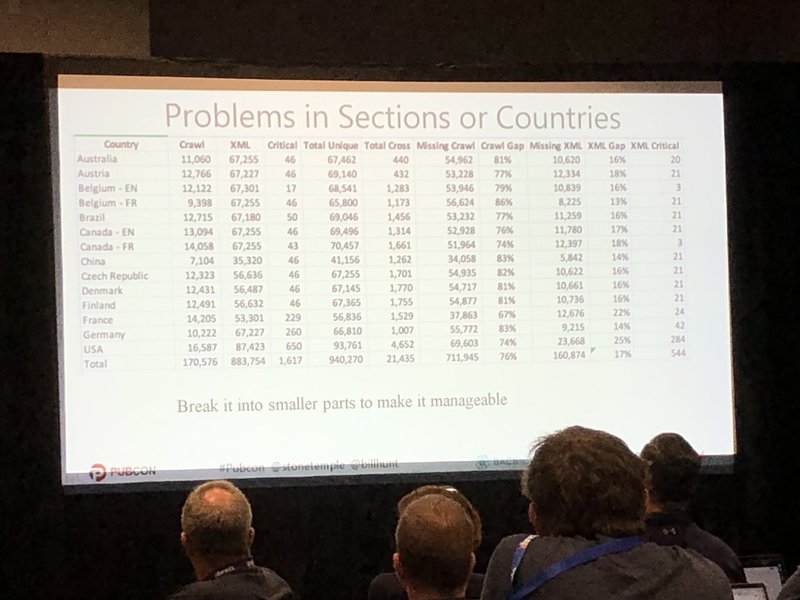

ページソースのアラインメント

HREFLang Builderを使えば、どこで、XMLが足りないか、がすぐわかります。これを同様に国ごとにもやった方がいいでしょう。

これをやると、以下のようなことがわかりました。

- 76%のXMLはクローリングされていなかった。

- 17%のクロールオエージはXML Site Mapに入っていなかった。

これは残念すぎですよね。HREFLang Builderで調べると、72%のエラーが検出されたのです。そのため、美しいXMLファイルを作りましょう。Always Follow RedirectsやRespect Canonicalという設定が入っていないことが多いので、注意してください。

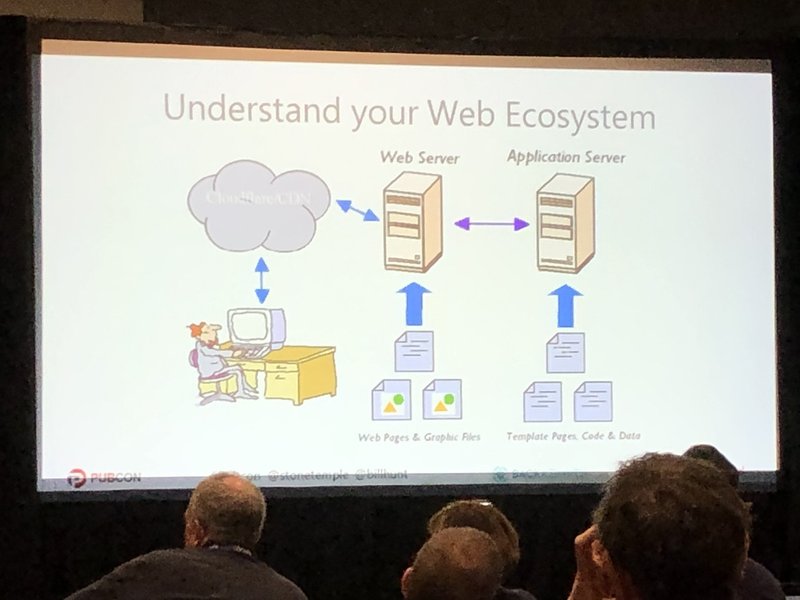

ウェブのエコシステムを理解する

SEOをやる前にWEBのエコシステムそのものを理解していないといけません。Cloudflare/CDNとウェブサーバーの関係、そして、ウェブサーバーとアプリケーションサーバーの関係を理解している必要があるでしょう。

504は弱いサーバーによって実は起きています。マックスまでインデックスしたくて、途中でサーバーがデータを返してくれなかったら、ダメですよね。例えばAkamaiはフロント部分です。ですが、後ろのウェブサーバーやアプリケーションサーバーがよくないと、結局インデックスはされなくなってしまいます。ですので、サーバーの状態を適切に保つことは非常に重要です。

また、sitemapのxmlは相対パスではなく、絶対パスで書かないといけないのにそうなっていないケースや、SiteMapが見つからないなんてこともあります。また、調査によると、49%のUKのサイトは実はUSのサイトだった、なんてこともあります。

重要なのは"Thin Content"です。適切な範囲でコンテンツを薄くし、インデックスさせやすくするようにしましょう。

第1弾 2287文字

https://note.mu/nozomukubota/n/n59a3e93ad1e5

第2弾 949 文字

https://note.mu/nozomukubota/n/n5cf0dcde47e1

第3弾 2373 文字

https://note.mu/nozomukubota/n/nf192225fdcda

サポートされた費用は、また別のカンファレンス参加費などに当てようと思います。