アップルを支えるGoogleの頭脳:独自のエコシステムの構築を目指す

Googleが自社開発するAIタスク向けのASIC「TPU:Tensor Processing Unit」は、いまや、GeminiやGoogle CloudのAI処理の中核システムとして、Googleの各地のデータセンターで稼働しています。

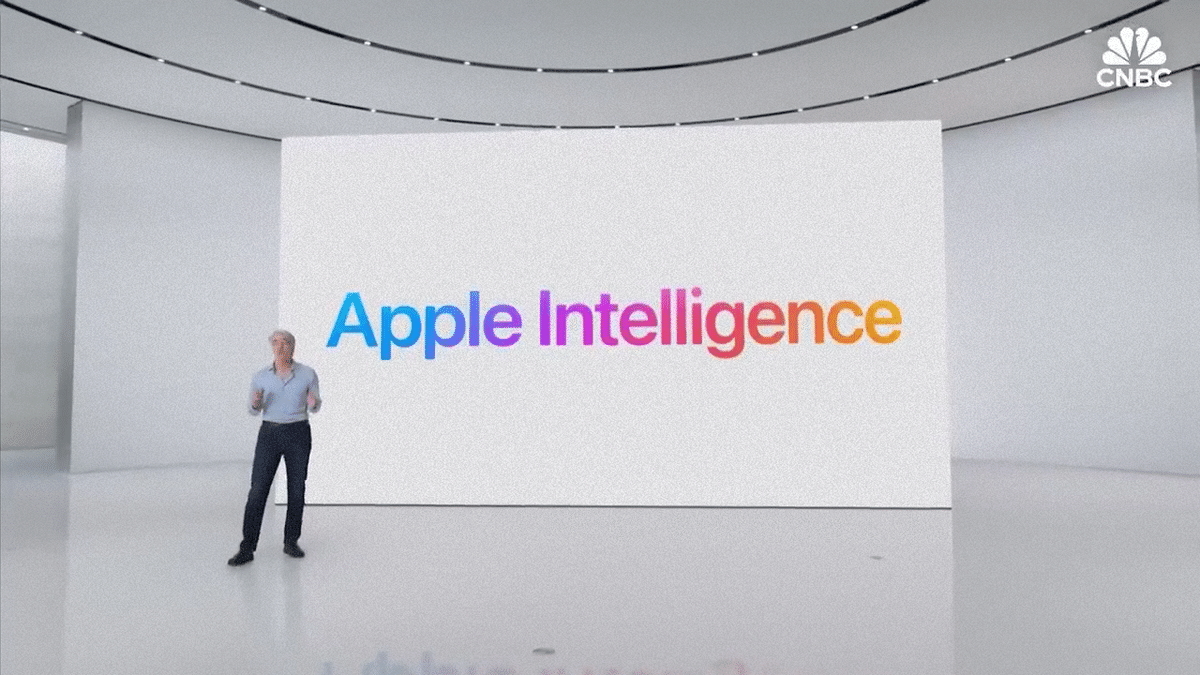

そして、アップルのApple Intelligenceを支える生成AIモデルも、このGoogleのTPUを利用してトレーニングが行われていることがアップル自身から発表されています。

マイクロソフトやアマゾン、メタのようなハイパースケーラーからは、NVIDIAもしくは、AMD、もしくは、自社で各々開発するアクセラレータチップによって自身のAI関連サービスを強化しているとの声が聞こえていましたが、一方、アップルからは、あまりNVIDIAの名前が聞こえてこなかったのは、このGoogleとの提携が背景にあったわけです。

Googleは、生成AIの競争においてOpenAIに遅れを取ったと言われていましたが、カスタムチップの自社開発においては、先駆者としての独自の道を歩みながらエコシステムを拡大しているようです。

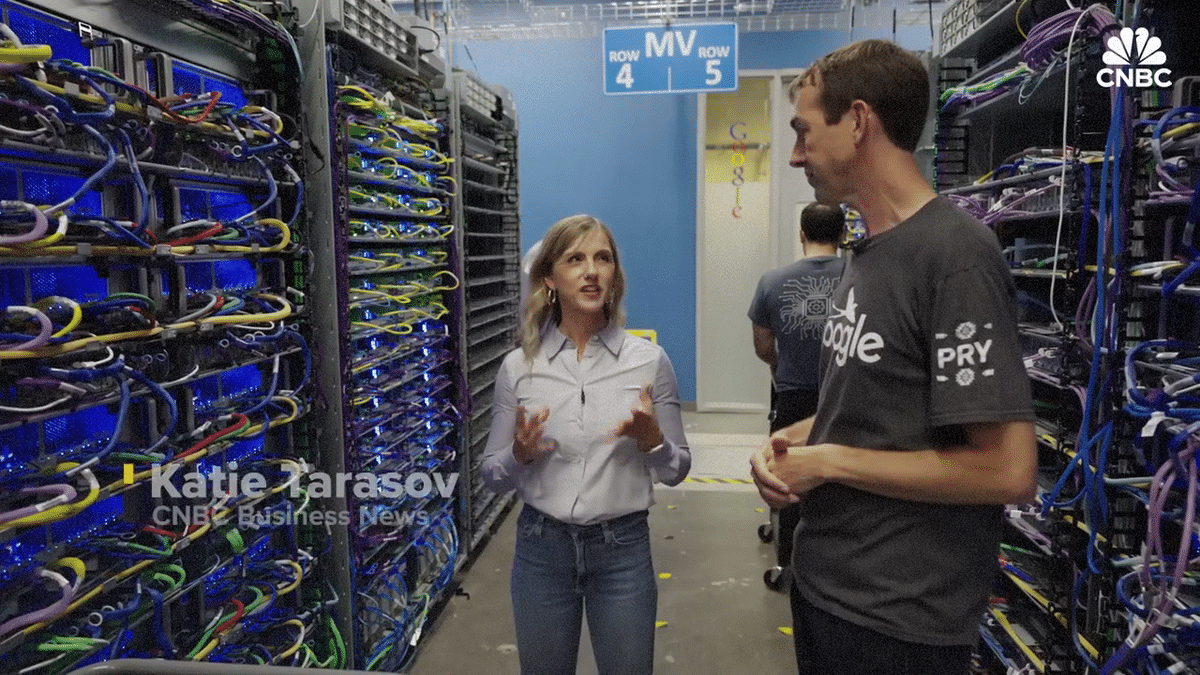

この投稿は、Googleのシリコンバレーにある研究所のTPU開発の最前線に訪れ、同チームを統括する副社長へのインタビューを含む、TPU開発の成り立ちと舞台裏、そして、Googleの目論見を紹介するCNBCのビデオコンテンツを紹介するものです。難しい話は抜きにして、ご参考頂けると思います。

1. イントロダクション

シリコンバレーにあるGoogleの本社の中の広大な研究所に並ぶ無数のサーバー全てがGoogle Cloudの顧客のために稼働しているわけではありません。

ここにあるのは、私たちが最初に作ったTrillium(トリリウム)システムの一つです。ここにあるのは、ラックごとに256個のチップが搭載されたTrilliumシステムの完成型です。

さらには、YouTubeや世界で最も利用される検索エンジンのために稼働しているわけでもありません。

Trilliumとは何でしょうか?

Trilliumは、私たちの最新世代のTPU(Tensor Processing Unit)のことです。今年の後半に社外公開される予定です。

その代わり、これらのサーバーは、Trilliumシステムの中核を成すTensor Processing Unit(TPU)のテストを行っています。そして、これらのTPUが、システム全体を支える重要な役割を果たしています。

検索エンジンやYouTubeの広告を含む、あらゆるGoogleのサービスは、さまざまな形で自社が開発したTPUによって支えられています。

現在、TPUはGoogleのチャットボット「Gemini」のような生成AIモデルのトレーニングにも使用されています。そして、最近の大きなニュースとしてこのTPUは、AppleのAIにも活用されています。

実は、7月末にAppleが発表した論文で、Googleのチップが使用されていることが明らかになりました。

世の中では、すべてのAI大規模言語モデルがNVIDIAのチップで訓練されているという一般認識があるのですが、Googleは独自の道を選んでいます。

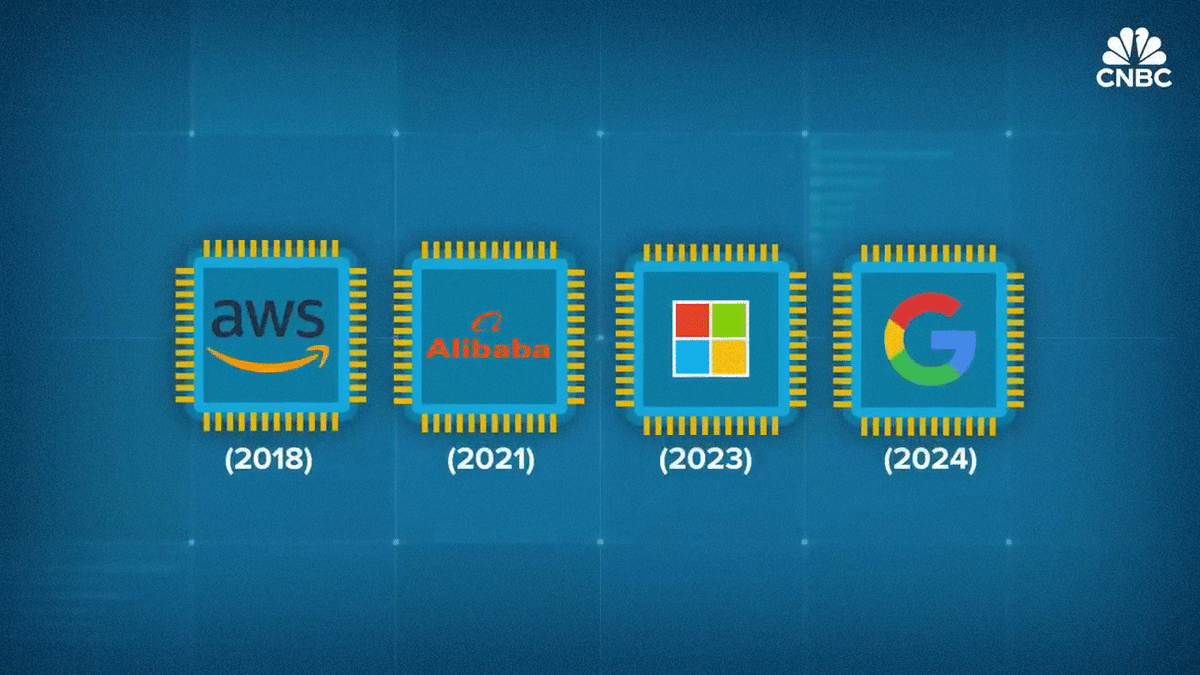

とはいえ、生成AIの基礎となるいくつかの重要な概念が生まれた場所であるにもかかわらず、GoogleはAI競争で後れを取っていると言われることが少なくありません。しかし、Googleは大手クラウドプロバイダーの中で最初にカスタムAIチップを開発した企業です。

ちょうど10年前、当時の音声認識のニーズを満たすため、我々はカスタムハードウェアを設計する必要があると判断しました。

以降、アマゾン、マイクロソフト、メタもAIチップの自社開発を進めています。

この場所で、チップやボードの電源を初めて入れて、仕様通りに正常動作するか確認し、潜在的な問題をデバッグする作業などを行っています。

ここにメディアが入るのは今回が初めてですね。

CNBCは、Google本社を訪れ、チップラボの内部を独占的に見せてもらい、そしてGoogleがなぜ、どのようにして高額で複雑なカスタムチップ・ビジネスに賭けているのかを最高幹部に直接伺いました。

2. トレンドの始まり

すべての始まりは2014年、Googleのあるグループが、想定した音声認識機能を立ち上げるためには、データセンターのコンピュータの数を倍増させる必要があることを計算で導き出したときでした。現在カスタムクラウドチップ部門の責任者であるアミン・ヴァーダット氏は、その4年前にGoogleに入社しました。

数名のリーダーが、「もしGoogleのユーザーが1日に30秒だけ音声でGoogleとやり取りしたいとしたら、どれだけの計算能力が必要になるのか?」という疑問を設問化して計算を行いました。その結果、汎用ハードウェアではなく、カスタムハードウェア、つまりこの場合はTensor Processing Unit(TPU)を構築することで、はるかに効率的に実現できることに気づいたのです。実際、その効率は通常の100倍に及びました。

Tensor Processing Unit(TPU)とは何でしょうか?その用語を作ったのもGoogleなのでしょうか?

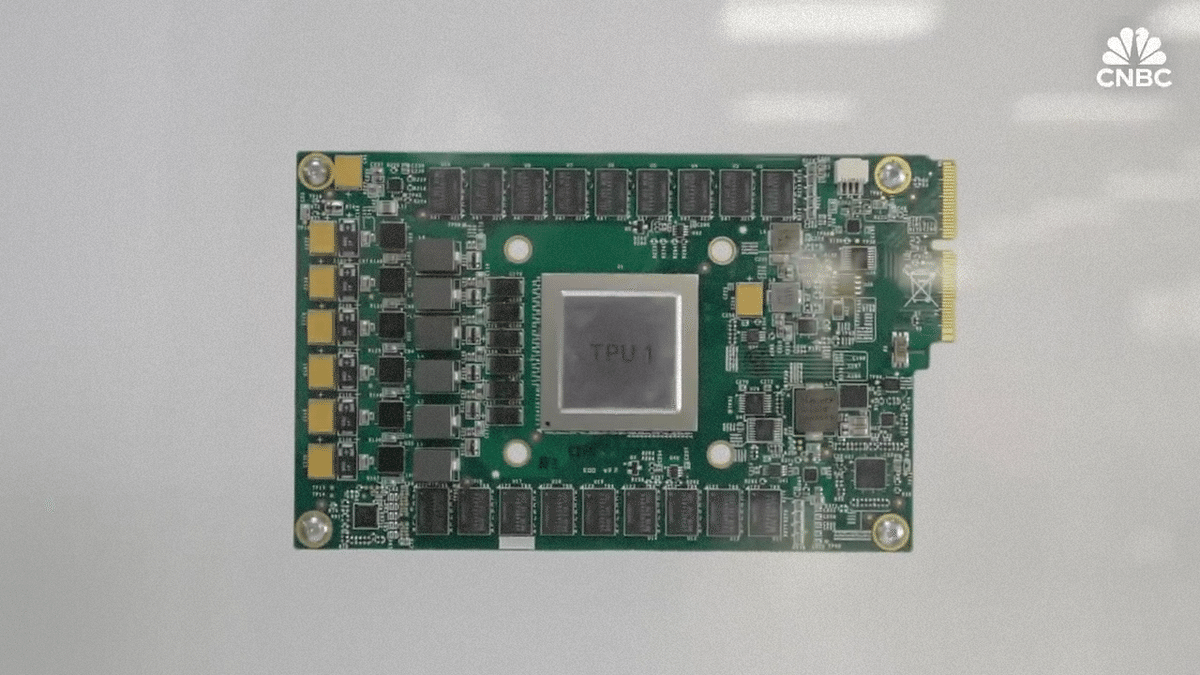

そうです。我々が「Tensor Processing Unit(TPU)」と名付けました。いうこれは、AIアプリケーションのための最初の大規模なハードウェアアクセラレーターです。

ここで、電力、熱管理、機能性などに関し、さまざまな検証やテストを行っています。大量生産や大規模な運用でも問題なく動作するよう、設計に十分な余裕があるかを徹底的に確認しています。

私たちが訪問した後にGoogleを退社した主任エンジニアのアンディ・スウィング氏は、TPUの最初のローンチにも関わっていました。

内部には、4つのチップが搭載されています。そのうち2つは、CPUを備えたホストマシンに接続されています。そして、このカラフルなケーブルはすべて、Trilliumチップをリンクして、一つの大規模なスーパーコンピュータとして動作するようにしています。

Googleのデータセンターは、依然としてIntelやAMDといったチップメーカーのCPUや、NVIDIAのGPUに大きく依存しています。一方で、GoogleはASICという別のカテゴリーのチップも開発しています。これらのチップは特定の目的のために設計されているため、より効率的に処理を行うことができます。

Googleで最も有名なASICは、AIに特化したTPUですが、YouTubeの処理を支えるためのVCU(Video Coding Unit)というASICも開発しています。

その他、GoogleもAppleと同様、自社のモバイルデバイス向けにカスタムチップを開発しています。G4チップは、AI機能を完全に備えた新しいPixel 9用のチップで、A1チップはPixel Buds Pro 2に搭載されています。但し、Googleを特徴づける存在にしたのはTPUの開発です。2015年に登場したこのTPUは、実に業界初のものでした。

AIクラウド時代になって企業の評価が大きく変わりました。このシリコンチップによる差別化、特にTPUの存在が、Googleがクラウド業界で第3位争いから抜け出し、他の2大クラウドと同等、場合によってはAI分野で先行していると見なされるようになった大きな要因の一つかもしれません。

Amazon Web Servicesは、Googleが最初のTPUを発表してから3年後の2018年に、初のクラウドAIチップ「Inferentia」を発表しました。また、Microsoftが最初のカスタムAIチップ「Maya」を発表したのは、2023年末になってからです。

差別化を維持し、競争力を保ち、市場の先を行くため、そして特定のサプライチェーンパートナーやプロバイダーに過度に依存しないようにするため、Googleはさらに多くに取り組み、自社でより多くの技術を開発する必要がありました。

ザ・フューチャラム・グループの調査によると、GoogleのTPUはカスタムクラウドAIチップ市場で58%のシェアを占めており、次いで、Amazonが21%で2位に位置しています。

3. AIとアップル

2017年に、8人のGoogle研究者たちが執筆した論文「Attention Is All You Need」で、現在の生成AIブームの基盤となる「トランスフォーマー」が生まれました。ヴァダット氏は、この発明はTPUによって可能になったものだと述べています。

トランスフォーマーの計算は非常にコストがかかります。もし、それを汎用コンピュータで実行しなければならないとしたら、誰もそのアイデアを思いつかなかったかもしれません。TPUが利用可能だったからこそ、このようなアルゴリズムを設計するだけでなく、それを効率的かつ大規模に実行する方法を考えることができたのです。

それでも、生成AIの激しい競争の中で、Googleは一部の製品リリースが失敗したとして批判を受けています。特に、Googleのチャットボット「Gemini」は、OpenAIのChatGPTよりも1年以上遅れて登場しました。

現在は、何十もの顧客がGeminiを毎日活用しており、その中には、ドイツ銀行やエスティローダーなど、非常に有名な企業も含まれています。また、マクドナルドなど、誰もが知っている多くの企業が利用しています。

Geminiは、TPUでトレーニングされたのですか?

Geminiは、TPUを使ってトレーニングされ、外部サービスも完全にTPU上で提供されています。

2018年、GoogleはTPUの利用用途を推論からAIモデルのトレーニングへと拡張しました。第2世代では256個のTPUを接続するポッドを導入し、現在稼働している第5世代では約9,000個のチップが接続されています。

このTPUシステムの本当の魅力は、すべてをダイナミックに光ファイバーで接続できる点にあります。そのため、必要に応じて小さなシステムから大規模なシステムまでシステム規模を自由に調整することが可能です。

2018年の第2世代TPUの登場以降、GoogleはTPUをサードパーティにも提供するようになりました。一方で、多くのクラウド顧客は依然としてNVIDIAのGPUを使用しています。

GPUは、TPUに比べてよりプログラマブルで柔軟性がありますが、供給が逼迫するなどの課題を抱えています。

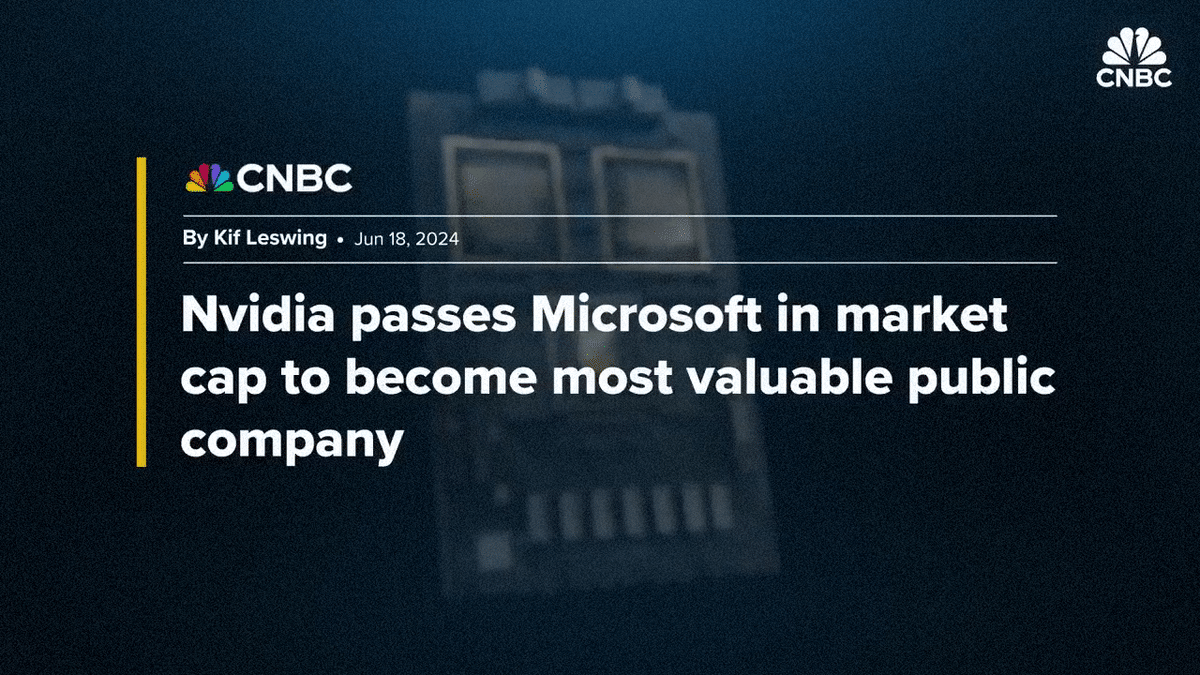

AIブームにより、NVIDIAの株価は急騰し、2023年6月には時価総額が3兆ドルに達しました。これにより、NVIDIAはGoogleの親会社であるAlphabetを上回り、AppleやMicrosoftと並んで世界で最も価値のある公開企業の地位を争うようになりました。

率直に言うと、これらの特殊なAIアクセラレーターは、NVIDIAのプラットフォームほど柔軟性やパワーがあるわけではありません。市場もその点に注目し、他の企業がNVIDIAの領域で競争できるかどうかが問われています。

AppleがGoogleのTPUを使ってAIを訓練していることが明らかになった今、本当の試練は、来年iPhoneやMacがそのAI機能を全面的に導入する際に訪れるでしょう。

Appleは、AIモデルを訓練するために、膨大な数のチップをGoogleから1時間あたり約2ドルでレンタルしていました。そのため、NVIDIAを必要としなかったのです。

現在の市場はNVIDIAが主導していますが、長期的には人々は単にAIを活用したいと考えるようになるでしょう。そのときには、TPUや他のAI専用の自社開発チップを使うことで満足するかもしれません。

4. ブロードコムとTSMC

しかし、NVIDIAの非常に強力で高価なチップに代わる選択肢を開発することは、容易なことではありません。

開発には多大なコストがかかりますし、大規模な取り組みが必要です。そのため、誰もができることではありません。しかし、ハイパースケーラーと呼ばれる企業は、その規模、資金、リソースを持っているため、それを選択することが可能なのです。

しかし、そのプロセスは非常に複雑で高額なため、Googleのような大企業でさえも単独で進めることはできません。最初のTPUが誕生してから10年間、Googleは、ブロードコムと提携してきました。ブロードコムはMetaのAIチップ設計も支援しており、これらのパートナーシップを実現するために30億ドル以上を研究開発に投じていると述べています。

AIチップは非常に複雑で、多くの要素が含まれています。Googleは計算部分を担当し、ブロードコムは周辺の要素を手掛けています。具体的には、I/OやSerDes(Serializer/Deserializer)など、計算部分を取り囲むさまざまなパーツをブロードコムが担当してパッケージングも行っています。

設計の完成の後、チップの製造は、所謂「ファブ」と言われる製造工場で行われます。TPUの製造は、主に世界最大のチップメーカーで、世界の最先端半導体の約92%を生産しているとされるTSMCで製造されます。

中国と台湾の間で最悪の事態が発生した場合に備えて、何か対策を講じていますか?

はい、そのことは重要課題であり、私たちもその可能性に備えて準備しています。ただ、実際にはそのような事態が起こらないことを願っています。

全世界が同じリスクを抱えていると思います。これはGoogleだけの問題ではなく、アマゾン、アップル、NVIDIAにも共通する問題です。台湾が適切な支援を受けられず、予期せぬ事態に直面すれば、それはこれらの企業だけでなく、世界全体に大きな影響を及ぼすことになるでしょう。

そのため、ホワイトハウスはCHIPS法に基づき、アメリカ国内でファブを建設する企業に対して520億ドルの資金を提供しています。その中で、最も多くの資金がインテル、TSMC、サムスンに割り当てられています。

これまでのところ、インテルとTSMCは、自社資金も多く投入しています。そのことは心強いことですが、同じものを再現するには時間がかかるため、だからこそ、再現する必要がないことを願っています。

5. プロセッサと電力

リスクはありますが、Googleは新たな大きな一手を打ちました。それは、同社初の汎用CPUとなる「Axion」の開発と年内提供開始の予定です。

これで最後のピースであるCPUを手に入れることができます。これにより、BigQueryやSpanner、YouTube、広告など、多くの自社のサービスがAxion上で稼働します。

GoogleはCPU市場への参入が遅れています。Amazonは2018年に「Graviton」を発表し、Alibabaは2021年に自社のサーバーチップを発表。Microsoftも2023年11月に自社製CPUを発表しています。

なぜ、もっと早く手を打たなかったのですか?

我々は、お客様に最も価値を提供できる分野に注力してきました。まずはTPUやVCU、ネットワーキングから始めました。そして、数年前から、ARM ベースのCPUの分野においても我々の専門知識を活かすべき時が来たと考えたのです。こうした取り組みには数年の準備が必要ですが、今がそのタイミングだと判断したのです。

GoogleがAxiomのリリースを遅らせたことを非難するつもりはありません。Axiomはそれほど差別化された製品ではなく、供給の問題や利益率、垂直統合の戦略に関わるものだと思います。一方で、TPUは真に差別化された製品であり、6世代にわたる10年間の経験が詰まっています。

これらの非チップメーカーからのプロセッサ、GoogleのAxiomも含めて、すべてはARMチップアーキテクチャによって実現されています。ARMは、インテルやAMDの従来のx86モデルに対し、よりカスタマイズ可能で省電力な代替手段として注目を集めています。省電力性は非常に重要で、2027年までにAIサーバーは年間で小国ほどの電力を消費すると予測されています。TPUのようにカスタマイズ可能なチップは、省電力性を大幅に向上させることができます。

こちらが第2世代の光回路スイッチです。我々の大型TPUスーパーコンピュータは、実際に光接続で相互接続されています。これにより、TPUチップをダイナミックにリンクし、実行中のタスクに合わせて構成をカスタム調整することができます。これらのシステムもすべて社内で開発されたものです。

電力問題は非常に重要な課題であり、効率を向上させ、コストを削減し、電力を節約できることなら、どんなことでも取り組むべきだと思います。

Googleの最新の環境報告書によると、2019年から2023年にかけて排出量が約50%増加しました。これは、AIの稼働を支えるためのデータセンターの拡大が一因となっています。

これらチップの効率性が寄与していなければ、排出量の数字は全く異なる結果になっていたでしょう。我々はインフラからの二酸化炭素排出量を24時間365日、ゼロに近づけるために取り組み続けています。

AIのトレーニングや運用には、大量の水が必要です。サーバーを24時間365日冷却し続けるためです。そのため、Googleは第3世代のTPUから、直接チップに冷却液を供給する「Direct-to-Chip Cooling」の仕組みを導入しました。この新たな冷却方法は、使用する水の量を大幅に削減でき、NVIDIAの最新GPU「Blackwell」にも採用されています。

4つのチップがあり、これらが液冷ラインに接続されています。ここには冷却プレートがあり、その内部には小さなフィンが配置されています。このフィンがチップから熱を吸収し、その熱を水に移して排出します。

地政学的な課題や電力・水資源の問題にもかかわらず、Googleは生成AIツールの開発だけでなく、その膨大な計算能力を支えるための自社チップの製造にも全力を注いでいます。

これまで、このような状況に出会ったことはありません。この勢いは、まだ衰える兆しもありません。今後5年間で業界に何が起こるかを予測するのは難しいですが、ハードウェアが非常に重要な役割を果たすことは間違いないと思います。

6. オリジナル・コンテンツ

オリジナル・コンテンツは、以下リンクからご覧になれます。

尚、本投稿の内容は、参考訳です。また、意訳や省略、情報を補足したコンテンツを含んでいます。

CNBC

(Original Published date : 2024/08/23 EST)

以上です。

御礼

最後までお読み頂きまして誠に有難うございます。

役に立ちましたら、スキ、フォロー頂けると大変喜び、モチベーションにもつながりますので、是非よろしくお願いいたします。

だうじょん

免責事項

本執筆内容は、執筆者個人の備忘録を情報提供のみを目的として公開するものであり、いかなる金融商品や個別株への投資勧誘や投資手法を推奨するものではありません。また、本執筆によって提供される情報は、個々の読者の方々にとって適切であるとは限らず、またその真実性、完全性、正確性、いかなる特定の目的への適時性について保証されるものではありません。 投資を行う際は、株式への投資は大きなリスクを伴うものであることをご認識の上、読者の皆様ご自身の判断と責任で投資なされるようお願い申し上げます。

この記事が気に入ったらサポートをしてみませんか?