# 216-H_SFドローイング&ライティング

形式

公開ワークショップ

入り時間

2022年2月19日(土)10:00

出演者

概要

本展を企画運営者らによって立ち上げられたひとつのフィクションとして捉え、SF小説やSF漫画の執筆を実践してきたアーティストや情報工学研究者とその物語の次の展開をドローイングの生成や架空の論文執筆を通じて夢想する。

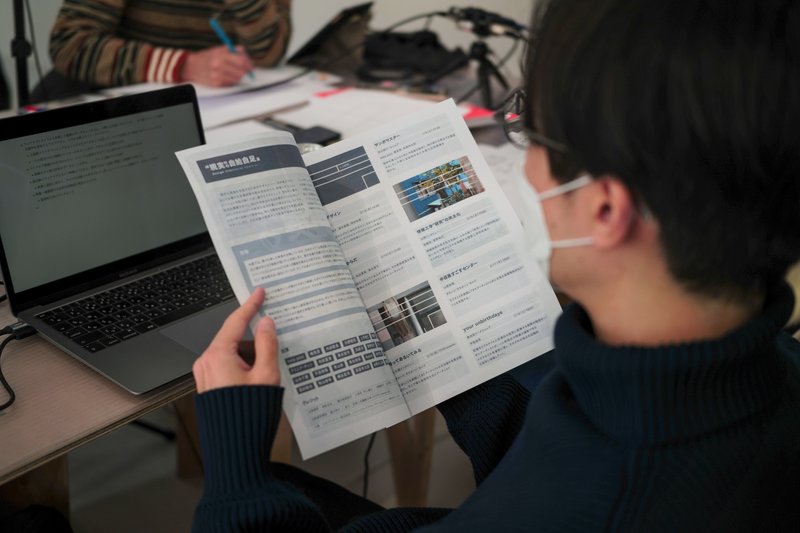

フォトレポート

菅野氏による架空の論文

メモ

散歩からのサンプリング

固有の記憶の可視化

研究アイデア

ウェアラブルカメラから収集した動画のデータセットを元に、大勢には見過ごされがちな、一方で個人にとっては重要な箇所を発見するアルゴリズム、とそれを使ったフィールドスタディ

大規模クラウドソーシングをもとに巨大なデータセットを作って、カメラ位置を全て都市の中にマッピングする

一つの都市の中に複数のレイヤーがあることをデータをもとに定量的に示す

ライフログ情報のみを手がかりに、ユニークな現実を生きている人同士のペアを発見できるか

映像ログと個人特性のデータセットを作る。ここでいう正解ラベルは何?

脳活動とウェアラブルカメラ映像のペアから、現実ではなく記憶に準拠した映像を生成する

映像と脳波に加えて、その人が記憶のみを手がかりに作ったアニメーション映像のデータセットを作る

脳波以外にも使える情報は使う、観た映画とか聴いた音楽とか

映像・画像間の文化的引用関係を検出するモデル

視覚的引用のデータセット

その個人固有の現実・記憶が記録できるようになったとして、その機械翻訳アルゴリズムを作る

他者の「現実」を体験することは本当に可能なのか

本来は、コンテクストまで説明しないと体験したことにならない ←この説明まで生成する

論文タイトルなど

ユーザ介入型マルチモーダル当事者映像生成

近年、ウェアラブルカメラやライフログデバイスの普及率が高まり、ユーザの生活を記録することそれ自体は十分可能になりつつある。しかしながら、映像そのものが捉えるユーザの当事者性には限界があり、インターネット上に存在する大量のログ映像から体験の固有性を読み取るのは容易ではない。本研究では、一人称視点映像と脳活動記録を元に、ユーザ固有の現実を捉えた映像を生成するためのアルゴリズムおよびそのユーザインタフェースを提案する。提案手法は元となる映像および脳波情報に加え、ユーザ任意の外部テキストや映像、音情報を参照入力として当事者映像を出力する。ユーザはリアルタイムに出力される映像を確認しながらインタラクティブに参照入力のフィードバックを加えることで独自の当事者映像を生成できる。被験者実験を通して、本研究で作成したプロトタイプシステムの効果を示す。

当事者体験翻訳のための大規模データセット

映像を用いた大規模調査の発達により、実空間における固有の現実の多様性が実証・可視化されつつある。しかし、データから発見される新たな文化的当事者性とその体験言語を理解することは容易ではなく、日々細分化する異なる文化的トライブ同士のコミュニケーション手段の欠落が問題となっている。島影らの先行研究では一人称視点映像アーカイブと展示キュレーションにより対話の機会創出を試みたが、これを自動化するのは容易ではない。本研究では、このようにデータから新たに発見された「現実」に対する文脈の説明を自動的に生成し、体験そのものを他者に翻訳する技術を確立するためのデータセットを提案する。1ヶ月にわたるワークショップを通して、当事者映像生成ツールの利用ログを記録し、さらにランダムな参加者ペア同士で生成した当事者映像を説明するセッションから対話の記録を取得した。機械翻訳に基づくベースライン手法により、当事者による説明を予測・生成した場合の精度を合わせて報告する。

青山氏による振り返りテキスト

2023-01-05_更新

この記事が気に入ったらサポートをしてみませんか?