Tech Miningの心得

はじめに

特許や論文といった科学技術情報を分析して、何らかの意思決定に繋げていく活動のことを表す用語が色々とあります。例えば、三位一体経営、IPランドスケープ、コンペティティブ・テクニカル・インテリジェンス、科学計量学(書誌計量学)等。今回は、その中でも特にドキュメントというコンテンツを分析し、書誌情報と掛けわせて分析する意味合いを色濃く持った「Tech Mining(テックマイニング)」を紹介します。

本記事は、この用語を提唱しているAlan L. Porter教授(Director, Technology Policy and Assessment Center, Georgia Tech) が2015年に執筆した"Tech Mining of Science & Technology Information Resources for Future-oriented Technology Analyses"を参考にしつつ、私の経験・意見も織り交ぜて執筆しています。Tech Miningだけでなく、データ分析全般的に言えることも多いと思うので、元ネタも直接読んでみることもオススメします。

Tech Miningとは

Tech Miningは、"text mining of science & technology information resources"の略称です。テキストマイニングと明記してある通り、ドキュメントのコンテンツの分析が根底にあり、書誌情報などと組み合わせていく考え方になります。目的は技術経営や科学技術イノベーション政策の問いに答えることです。

私は、テキストマイニングも、書誌情報分析も、その他の定量・定性分析も、手段として平等であり、プロジェクトの目的の元、適切に選択と試行を繰り返せばいいと考えています。後述しますが、Tech Miningでも、解くべき問いを設定し、適切な方法とデータを選択せよ、と言っています。また、コンペティティブ・テクニカル・インテリジェンスが上位概念とも言っているので、テキストマイングを絶対にやるべき、という話ではなく、コンテンツベースの分析としてのテキストマイニングに注目しつつ、色んな手法を組みわせて目的を達成せよ、という考え方だと理解しています。

問いを設定せよ

Tech Miningの分析フローを紹介します。これはTech Miningだけでなく、データ分析一般的に言えることだと思います。どのステップも重要ですが、個人的に大切だと感じているのが、1・2・8・9・10です。

1. 問いを整理して解答方法を考案

2. 適切なデータの取得(主に科学技術情報)

3. 反復的な検索

4. データ分析ツールの活用

5. データ加工(整理と統合)

6. 分析

7. 可視化

8. Web上の情報や専門家の意見との統合

9. 結果の解釈・要約・伝達

10. プロセスの標準化・半自動化

1. 問いを整理して解答方法を考案

まず全ての源流となる問いがないと分析を進めることはできません。「何を明らかにして、その結果、どんな意思決定・アクションをしていきたいのか」を明確化する必要があります。データ分析は手段として面白いので、ついつい手段の目的化や複雑化に走りやすいです。そんな時も、プロジェクトメンバーと共に、「そもそも私たちは何がしたかったんだっけ?」、「それをシンプルに解くにはどうすればいいか?」という、立ち戻れるアンカーとしての役割もあります。

その後、適切なデータ、分析手法を考案していきます。データを触っていくうちに初めて知る情報や他の手法を思いつくこともあります。初めにガッチリと決めて、プロジェクト中は全てこの通りにしないといけない、と言ったものではなく、ある程度余白を持たせた設計(手法と計画)が大切かと思います。

2. 適切なデータを取得

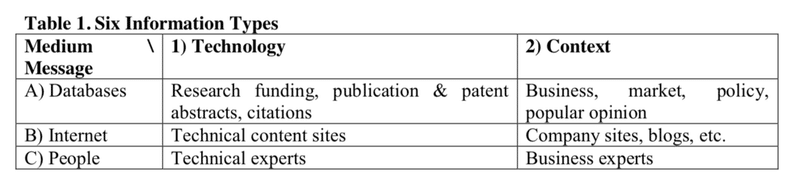

手法だけでなく、やはり「データ」の特徴を理解する必要があります。そうでないと、目的に応じたデータ取得ができません。どんな情報が、どんな形式で蓄積されているのか。どのような制約条件があるのか。どのように取得できるのか。データのデータ(メタデータ)を自分の中に構築しておくと良いと思います。なお、Porter教授はメディア(データベース or インターネットor 人伝て)と内容(テクノロジー or 文脈情報)の組み合わせで、6つに整理しています。多くのテクノロジーマネージャーは、AとBの情報がうまく活用できていないのではないかと指摘しています。Tech Miningは、これまでの人間が蓄積してきた知を活用して、巨人の肩に乗るためのデータ分析だと私は認識しています。

8. Web上の情報や専門家の意見との統合

特許や論文といった科学技術情報から、注目すべき人物や組織、研究領域を発見した場合、今現在の状況を知るには、他のデスクトップ調査やインタビュー調査などが必要です。注目すべき人物・組織・研究領域について、彼らのWebページを確認し、最新の取り組みを理解することはもちろんのこと、LinkedinやCrunchbaseなども併用し、興味のある人物がどんなキャリアを経ているのか、どこかのスタートアップのアドバイザリーをしていないか(もしくは自分で起業していないか)、といった情報も組み合わせていくことも考えられます。

また、データ分析のプロジェクトには、データ分析が強い方(アナリスト)とドメイン知識を持っている方(ドメインエキスパート)で構成されていることが多いと思います。その両者の協力は重要であり、アナリストが開発したメトリクスなどに対して、ドメインエキスパートがどう感じたのかを、お互いに確認し合いながら、ブラッシュアップしていけるといいと思います。納得できるところはさることながら、違和感があった場合もその理由を深掘りすることで、新たな発見に繋がるかもしれません。

9. 結果の解釈・要約・伝達

先のアナリストとドメインエキスパートの協業もそうなのですが、やはり、出てきた結果をどう解釈するかは、その人々が置かれている環境に依りますし、それこそ人間の力だと思います。

また、意思決定・アクションに繋がっていくために、データ分析結果や解釈を、どのように表現して伝達していくか、も考える必要があります。この後、どんな人を巻き込んでいくのか、どんな業務を行うのか、といったことを想像しながら、情報を整理して表現する「情報デザイン」の考え方が重要だと思います。

10. プロセスの標準化・半自動化

データ分析は試行と型化の繰り返しだと思います。データと格闘し、仲間と議論していく中で、良い手法が生まれていきます。この時はアドホックな分析を試行錯誤しますが、次回からは効率よく実施するために、うまくいったプロセスを標準化したり、プログラミングで半自動化しておくといいです。きっと、プロジェクトテーマごとに変わってくるところがあると思うので、半自動化された状態から実施するか否かで、ブラッシュアップや組織学習の速度が大きく変わってくると思います。

How・Whyには答えられない

Tech Miningにおける注意点としては、答えられる問いの種類を認識しておく必要がある点です。具体的には、Who、What、When、Whereといった問いには答えることができます。ただし、How(プロセス)、Why(理由)という問いには答えることはできません。これはTech Miningだけでなく、データ分析全般的に言えることかもしれません。

算出した指標等を解釈するには、ドメイン知識を持った人の関与が必要です。また、クラスタリングやマッピングは単一の正しい方法ではなく、ユーザーに利用され、解釈・洞察をもたらすことで価値が発揮されます。そういった意味でも、データ「分析」だけでなく、データ「活用」いうマインドセットが大切だと思います。ちなみに、日立製作所・知財部の講演の中で、「データ分析」と「データ利用」を明確に使い分けしていました。こういった言葉遣いから気をつける姿勢に感銘しました。

データ分析結果の活用:パケット化

「データ活用」において重要なポイントの1つとして、適切に人を巻き込み、アナリストとユーザー(意思決定者など)の関係性が強固になることが挙げられると思います。そこでPorter教授は、「パケット化(packetizing)」という概念を提唱しています。データ分析結果はユーザーのニーズに合わせて慎重に調整する必要があります。例えば、ユーザーに100ページの報告書を待たせる前に、ユーザーが必要としている観点について、ショートに成果を出して、咀嚼してもらうことが大事(パケット化)。これによって、ユーザー自身にも分析プロセスに参加することで、アナリストとユーザーの関係性が強固なものになっていきます。また、その他にも、アナリストとユーザーの間に色んな人を介在させずダイレクトに議論できること、複数のアナリスト・意思決定者を巻き込んでロバストかつ学習効果の高い組織ネットワークを構築すること等も、データ活用のポイントとして挙げています。

アナリストもユーザーも、お互いに不安に感じているところがあると思うので、お互いの見えている風景を、粗くても素早く共有し、咀嚼し合うことで解像度を高めていく、というのは大切なプロセスだと思います。最初に設定した目的や問いを参照しながら、重要な分析観点・結果・議論ポイント・軌道修正案等を適時適切にパケット化できるかが、データ分析プロジェクト推進の肝なのかもしれません。

参考情報

Porter教授のResearchGate

Porter教授の文献情報は、こちらのResearchGateから確認できます。

Search Technology Inc.

Porter教授はSearch Technology Inc.という会社を創業しており、VantagePointというTech Miningツールを提供しています。彼らの文献情報やプレゼンテーション資料などが下記サイトにまとまっています。

GTM Annual Conference

Tech Miningの学会として、GTM Conferenceが毎年開催されています。2020年の各セッションは、下記サイトでビデオが公開されています。2021年は11月に開催予定です。

GTM Virtual Forum

GTMはVirtual ForumというWebinarを定期的に開催しています。次回は4/15に、"Word2Vec for STI studies"というテーマで開催されます。科学技術イノベーション研究のための埋め込み技術の紹介です。

コンペティティブ・インテリジェンス

Tech Miningの上位概念として、コンペティティブ・(テクニカル・)インテリジェンスがあります。関連情報・書籍を下記にまとめておきます。

科学技術イノベーション政策の科学

「科学技術イノベーション政策の科学」に関するコンテンツとして、下記が挙げられます。無料で読めるもので、様々な研究者が執筆されています。科学技術イノベーション政策の形成プロセス、社会経済的インパクト評価、歴史・海外情報などがまとめられています。

科学計量学

科学技術情報分析の基本作法として、科学計量学を知っておくことは有益だと思います。書籍やWebで公開されている論文も多いですし、NISTEPの活動は科学計量学を駆使した分析機関としてウォッチしておくと良いです。国際的には、Scientometricsというジャーナルや、ISSI Societyという学会があります。また、特許情報分析については、最後の2冊がオススメです。参考情報が多くリストアップされていて周辺情報も紐解けるので、入門書にも適しています。

データ・テキストマイニング

私は大学生の時に、データ・テキストマイニングと出会いました。その時に入門コンテンツとして読み漁っていたのが、同志社大学・金教授と早稲田大学・豊田教授のコンテンツです。特に最初のWebサイトは、データ・テキストマイニングに関して幅広いテーマが紹介されたPDFが無料で読めます。数式からコード(R言語)まで紹介されており、おそらく、Rによるデータサイエンスの元になったコンテンツだと思います。また、豊田教授の「データマイニング入門」も数式からコード(R言語)までわかりやすいです。コード等は古くなっている部分もあると思いますが、どれもデータマイニングの面白さを感じられるコンテンツです。また、テキストマイニングについては、金教授の「テキストアナリティクス」が広くトピックがカバーされていてオススメです。ただ、データマイニングに知見のある方向けな気がするので、初学者の最初の1冊としてはハードルが高いかもしれません。

データ可視化・情報デザイン

データ可視化に関する書籍として、「Google流資料作成術」がオススメです。邦題だと資料作成のTips本のように見えますが、原著タイトルは"Storytelling with Data"で、データをどう表現して、ストーリーを語るか、という話です。その他、実務的なところであれば「データ視覚化のデザイン」、アカデミックな内容も知りたい場合は「意思決定を助ける情報可視化技術」もオススメです。また、(情報)デザインについては、「デザインの知恵 情報デザインから社会のかたちづくりへ」や「デザイン入門教室」が参考になります。

データ活用に関する書籍

データ分析ではなく、データ活用を意識せよ、という話は、こちらの本も参考になると思います。柏木氏は日産自動車におけるデータ活用とビジネス改革をリードされた方で、今はデータ&ストーリーLLCを創業しています。

「問い」に関する書籍

定番のものから、最近の書籍まで。2021年4月20日発売予定の「リサーチ・ドリブン・イノベーション 「問い」を起点にアイデアを探究する」も面白そうです。