ヒトとコンピューター3(エクリから)

第1回記事:ヒトとコンピューター1(エクリから)

第2回記事:ヒトとコンピューター2(エクリから)

第3回目となる今回も引き続きEKRITS<エクリ>に掲載中である水野勝仁氏による「インターフェースを読む」という連載を元に、そのモデルスケッチの清書と自身の考察を書いていきたいと思う。

今回は、第3回の『GUIが折り重ねる「イメージの操作/シンボルの生成」』の記事である。この「インターフェースを読む」という連載は、全部で5回分の記事がある。その丁度折り返し地点となる今回の記事は正直複雑だった。最初の2回の記事と比べると頭の中で抽象化しなければならないそれぞれの項目を自分が納得できる形に繋げること、さらにはそれを視覚を通して理解できるに形に落とし込むプロセスでかなり苦労した。加えて、ダイアグラムの形式をすでに設定してしまっているので、その形に合うようにピースを当てはめていく行為は中々の苦労だった。

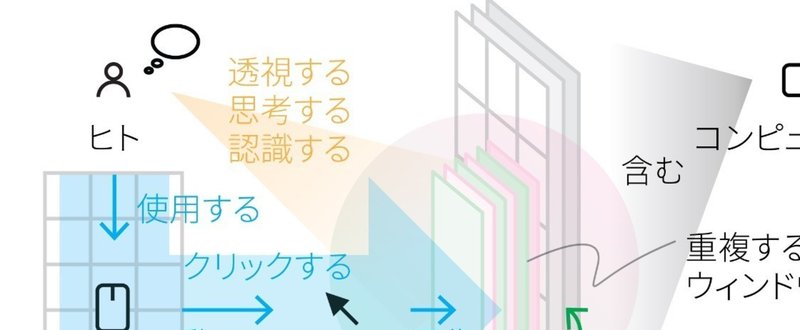

とりあえず前回のスライドから始めていきたいと思う。

インターフェースで合成する

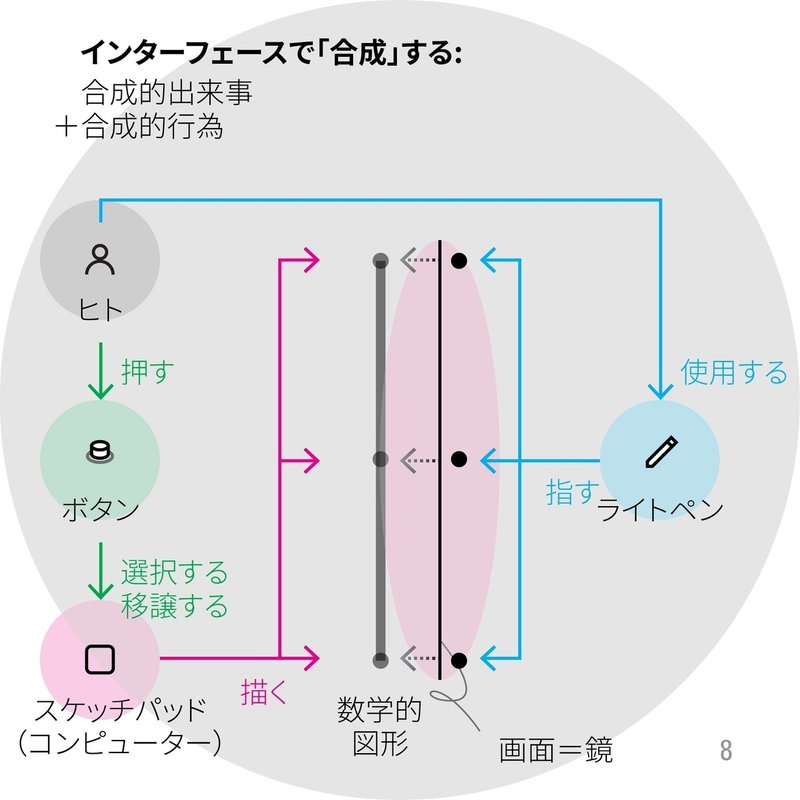

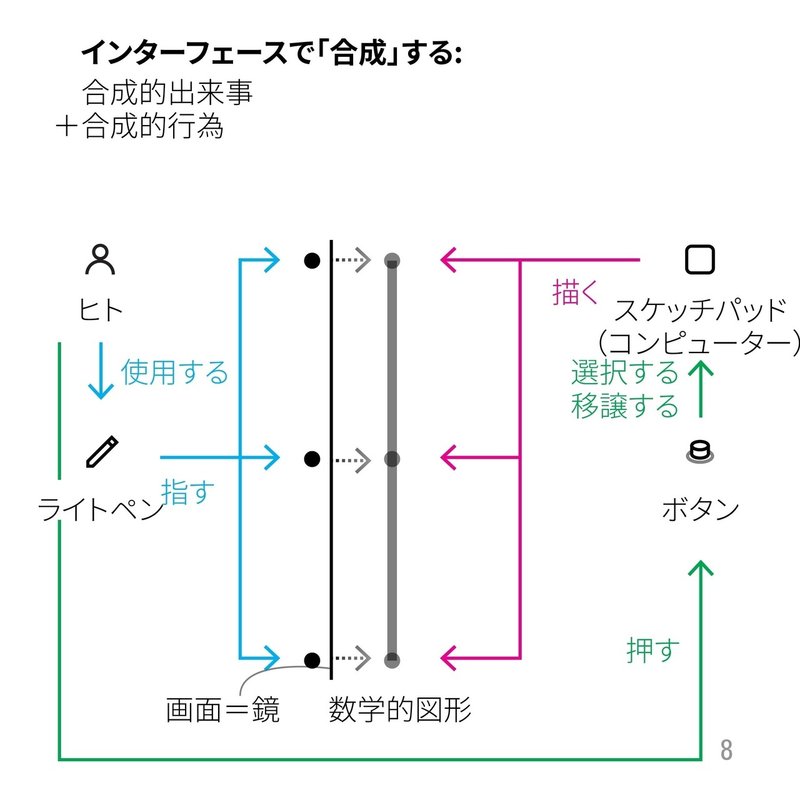

前回記事の最後の内容は、インターフェースにおける合成的出来事と合成的行為の違いを説明するポイントで終わっていた。第3回目の記事においては、ダグラス・エンゲルバートがヒトの知能の補強増大を目指した「NLS(oN-Line System)」で用いるポインティングデバイスとして、開発したマウスが生み出したヒトとコンピューターとの新たなインタラクションの考察から始まっている。自分の考察を進めるに際して、モデルのレイアウトを少し変更した。

ライトペンとボタンの位置が入れ替わり、前回のメインのコンピューターの例であったスケッチパッドの位置も左下から右上に変更している。

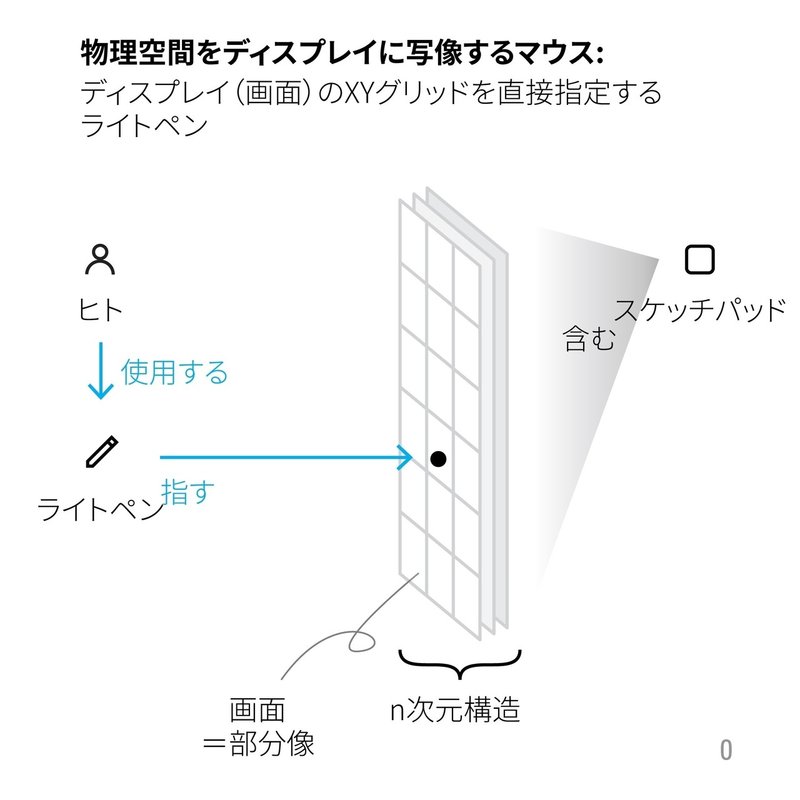

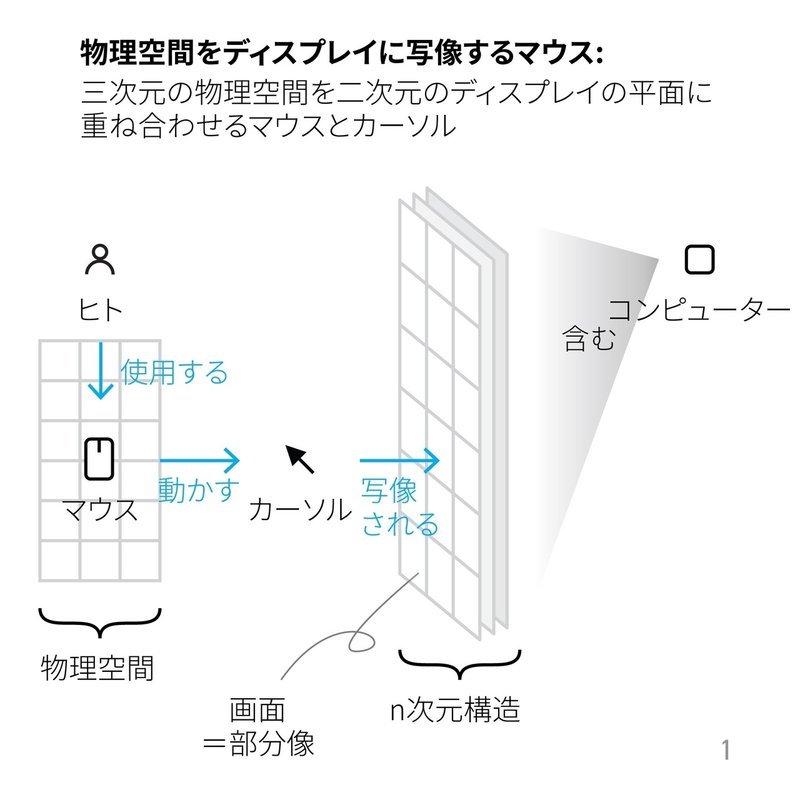

物理空間をディスプレイに写像するマウス

最初にモデルのレイアウトを変更したことには理由がある。それは、スケッチパッドにおけるライトペンとエンゲルハートが開発したマウスを用いたヒトとコンピューターのインタラクションの違いを明確にするためだ。

スケッチパッドを始めとする様々なタイプのコンピューターは、画面(ディスプレイ)をXとY軸に区切られたピクセル情報を介して、ヒトが理解することのできる文字や画像を映し出している。しかしながら、この画面はコンピューターの構造の一部分しか反映しておらず、ヒトが見ている最前列に存在する画面の背面にはさらにいくつもの次元が存在している。記事内ではこれをコンピューターのn次元構造と説明されていた。

ライトペンなどのペン型のデバイスは、このコンピューターが持つ画面の平面と対になり、直接XYグリッドの1地点を指し示すことでインタラクションを行なっている。

一方で、マウスはこのコンピューターの画面における平面と対になることを必要としない。代わりマウスと連動して動くカーソルがこの画面上に写像される。マウスはヒトが存在する物理空間上の平面(机や壁など)をコンピューターのXYグリッドと同様に区分けすることでその動きを、画面上のカーソルに伝達している。つまり、三次元上に存在する物理空間を二次元上に存在する情報空間とをマウスとカーソルを介して重ね合わせている。

ペン型のポインティングデバイスとマウスにおけるインタラクションの違いは、マウスはヒトとコンピューターとの間で発生した行為の最後の状態を保存することができるという点にある。

例えば、スタイラスとアイパッドを使って絵を描くときに、一度スタイラスから手を離してしまうとそれまでスタイラスが指し示していた画面上の点は消えてしまう。一方で、マウスにおいてはたとえヒトの手が離れてしまったとしても、画面上のカーソルの位置が変更されたり、消えたりしてしまうことはない。

「鼻」としてのマウスとカーソル

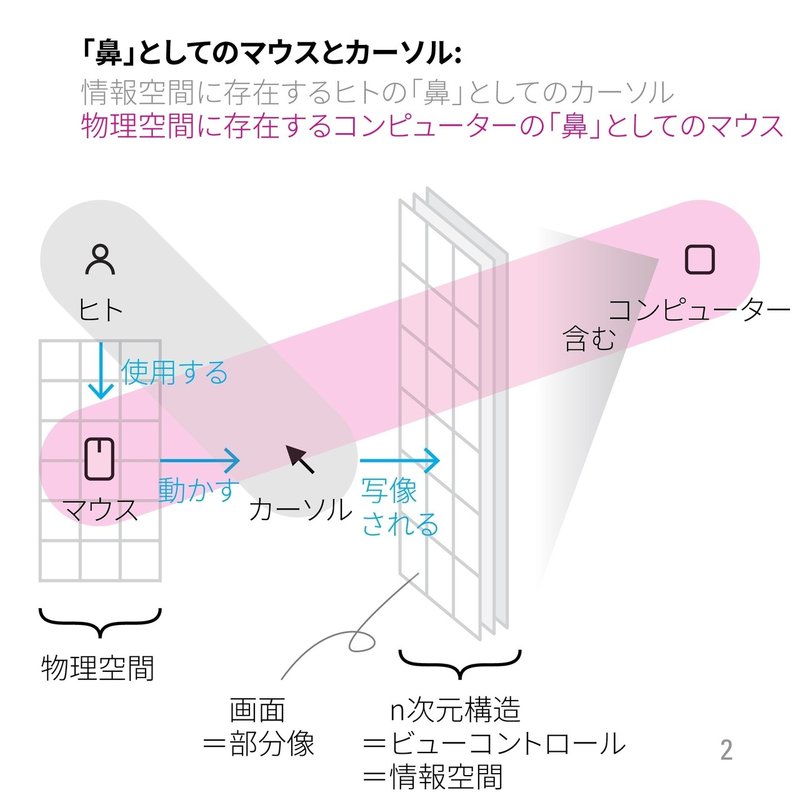

先にマウスとカーソルというコンビネーションがヒトが存在する物理空間とコンピューターが操る情報空間とを重ね合わせるデバイスであるということを説明した。この状況においてとのヒトとコンピューターが持つマウスとカーソルとの関係性を「鼻」という言葉に書き換えて考察してあったことが非常に面白いと感じた。生態心理学者のJ・J・ギブソンの解説を元に、ヒトは世界を認識する際に自らの鼻(腕、頭、足なども同様)を認識し、世界によって反射されたその鼻との両方を同時に認識しているというふうに説明があった。つまり、自身と世界との両方が存在しなければこの認識は成り立たないということになる。

同様に、ヒトは情報空間に存在するカーソルを自らの「鼻」として認識し、コンピューターは物理空間に存在するマウスを自らの「鼻」として認識しているというアナロジーが成立する。

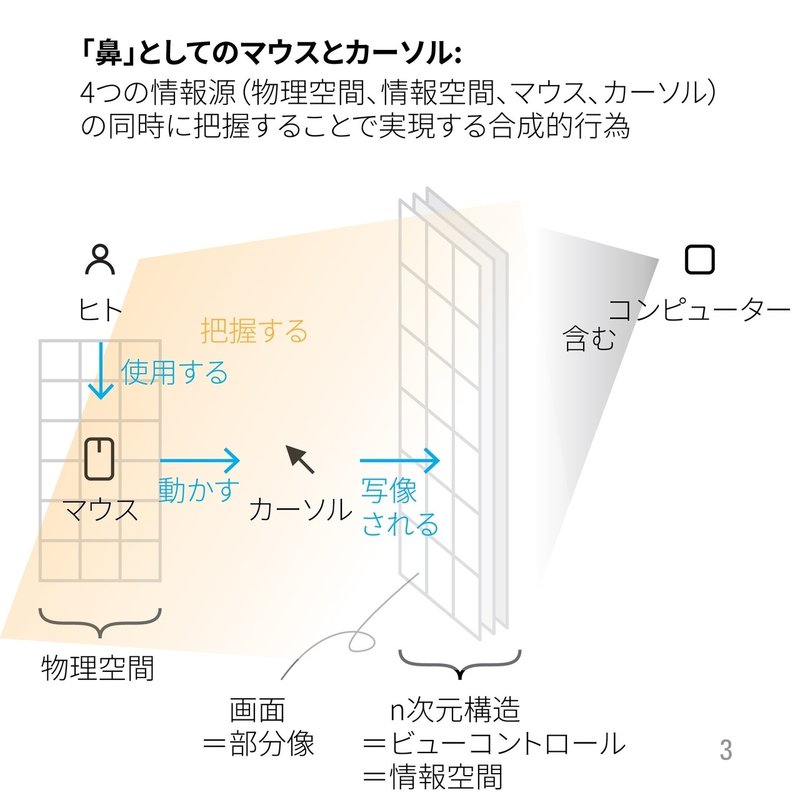

マウスとカーソルとを介して生じる合成的行為は、物理空間、情報空間、マウス、そしてカーソルという4つの情報源を同時に把握し、認識することをヒトに要求する。結果として、ヒトはマウスとカーソルを用いてコンピューターとの合成的行為をする際に、多動的になる。

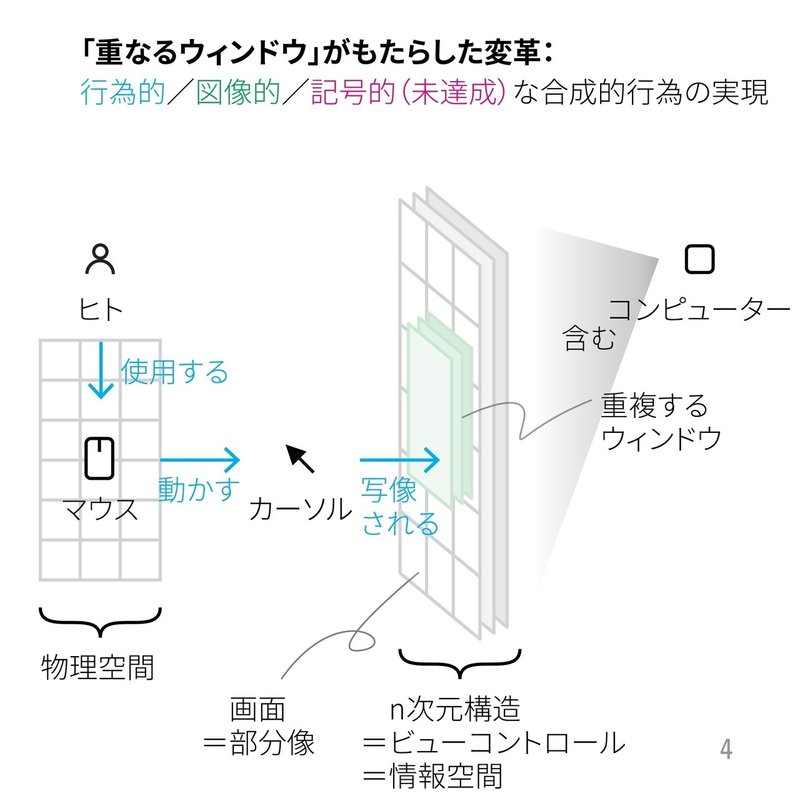

「重なるウィンドウ」がもたらした変革

アラン・ケイは「Doing with Images makes Symbols(イメージを操作してシンボルをつくる)」というスローガンを提唱した。これは、マウスを用いた行為によって、コンピューターの画面上のウィンドウ、ボタン、アイコンなどの図象的なオブジェクト操作し、記号的なシンボルを生成するというアラン・ケイがGUIの開発における目標を端的に示したものであり、実際のGUIの開発に大きな影響を及ぼした。最後の記号的なシンボルの生成という言葉があまりしっくりこないが、これは誰もがGUIを操作することでプロセスの抽象化を促し、プログラミングを可能にすることを指しているらしい。

現在の普段のコンピューターとのインタラクションを考えてみると、「イメージを操作する」という行為が大半を占めていることが理解できる。一般的な消費者は、GUIの操作からプロセスを抽象化するなんて行為は行わないし、GUIデザインにおける人間中心設計の考えは、この「シンボルをつくる」という行為をできるだけプロダクトやサービスの開発段階で取り除く行為とも解釈することができるので、アラン・ケイが提唱したスローガンが達成される時はさらに遠退いているようにも感じられる。

この状況を生み出した大きな原因になっているのが、「重なるウィンドウ」というシステムである。このシステムは、ヒトがコンピューターとインタラクションを行う際に「イメージを操作する」という行為に焦点を当てる結果となった。ヒトは、この重なったウィンドウを常に入れ替え操作し続けることで能動的にコンピューターとともに合成的行為を行う存在となった。

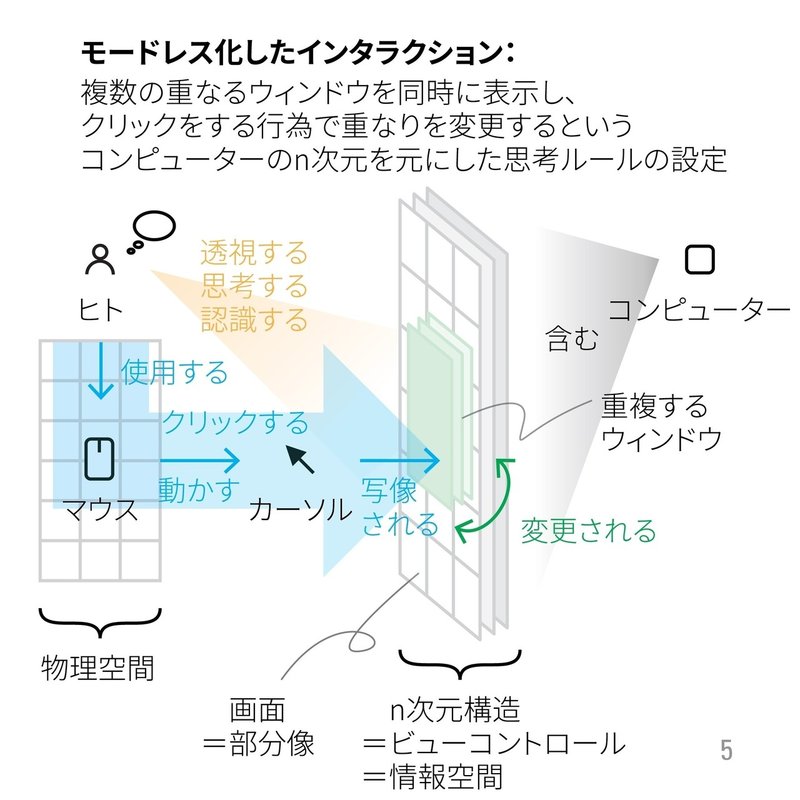

モードレス化したインタラクション

「重なるウィンドウ」のシステムが開発される以前には、「重ならないウィンドウ」というシステムが存在した。そのシステムは1つの機能をオンにしたり、オフにしたりすることで操作を切り替える「モード」という思考ルールを強要した。

ドン・ノーマンのDesign of Everyday Thingsの中でもこのモードについて記述されている箇所があった。基本的にヒトがこのモードを用いて行為を行うときに、自らの短期記憶領域の中に任意のモードか可能にする行為を記憶しておく必要があり、このヒトの短期記憶の能力に頼るインタラクションはミスを誘発しやすいことが述べられいる。

しかしながら、「重なるウィンドウ」のシステムにはおいては、それぞれのウィンドウの機能をモードによって切り替える必要がなくなり、クリックひとつで作業を行いたいウィンドウを最前面にもってくることが可能となった。すなわちモードレスインタラクションである。ここで重要となってくるのがカーソルの役割である。カーソルは、この複数の「重なるウィンドウ」の一番に上に常に存在することによってヒトが情報空間の中で、「鼻」としてのカーソルをいつでも確認できるようにしている。

結果として「重ならないウィンドウ」のシステムよりもはるかに多い情報を同時に表示しつつ、ヒトの目の特性である1つの対象を2つの視点から認識し、透視できることを生かしたインタラクションを可能にした。これは、コンピューター内のn次元構造を元にした新たな思考ルールの設定へと繋がった。

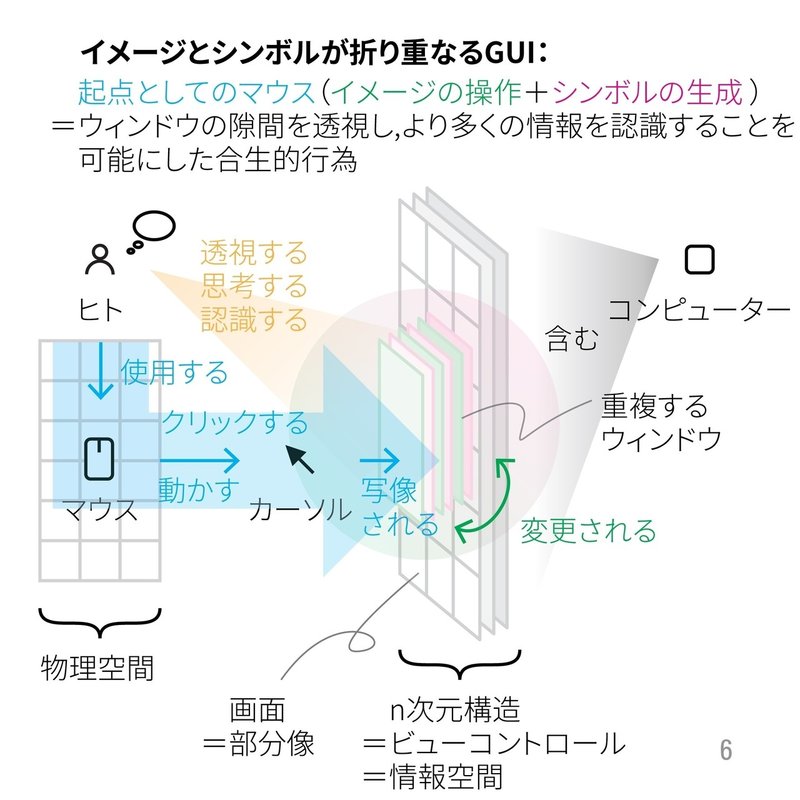

イメージとシンボルが折り重なるGUI

この「重なるウィンドウ」は、マウスを介したインタラクションをもって常に視点を能動的に変化させ続けることができるという能力をヒトに齎した。つまり「イメージを操作する」行為である。

先述したように「シンボルをつくる」という行為は、GUIの発展において抜け落ちているように感じられる。しかしながら実際には、この「シンボル」は、「イメージ」の背面に重なり合っている。なぜならGUIにおける「イメージ」は、この「シンボル」によって形作られているからである。わかりやすく言えば、ソフトウェアシステムにおける「ユーザーインターフェース」は、「プログラム」によって実現されている。その2つの面は、重なり合っているために最前面を切り替えて、どちらからの視点でも見ることが実際には可能である。

これがイメージとシンボルが重なるGUIの本質である。

まとめ

今回の記事の始めの方でも述べたが、第3回目の記事は情報の抽象化とともに視覚化することの両方ともかなり難しかった。正直まだ改善の余地は多くあると思うものの、残りの記事の考察を書いていくうちに最終的なマップにまとめるプロセスの中で色々とわかってくることもあると思う。

この水野氏の連載を読めば読むだけ自分の中では、Human-Computer Interactionと人間中心デザインは似て非なるものという解釈になっていく。

Human-Computer Interactionの研究においては、ヒトはコンピューターと同じ次元のフィードバックシステムの中に存在する。つまりは、ヒトはそのフィードバックシステムの要素の一部である。このシステムの中では、「イメージを操作してシンボルをつくる」というスローガンが成立する。

一方で、人間中心デザインでは、ヒトがフィードバックシステムの中心に存在し、それを取り囲むようなにコンピューターが並ぶ環状のシステムが連想される。このシステムの中では、「イメージ操作(前面)/シンボル生成(背面)」が重なるGUIでの行為が支配する。人間中心デザインの根本は、この背面にある「シンボル生成」をいかにプロダクト・サービスをつくる段階で抽象化して、効率よく隠すのかということに関わってくる。これは、合成的出来事のエコシステムマップ+合成的行為のメンタルモデル+ユーザーコンセプトモデルの作成がデザインプロセスの中で非常に重要であることを示唆する。

これは全て今のオフィスで学んできたことだ。社長であるヒュー・ダバリーのデザインに対する哲学と興味・関心の幅も理解できる。こっちの方が何十倍も面白い。今回の内容の発見とは、若干違うけれど以前書いたオフィスについての記事は興味がある人にとっては少しはやくにたつかもしれない。

という感じで今回はここまで。

基本的に今後も記事は無料で公開していきます。今後もデザインに関する様々な書籍やその他の参考文献を購入したいと考えておりますので、もしもご支援いただける方がいらっしゃいましたら有り難く思います🙋♂️